自动驾驶数据与具身智能数据有哪些区别?

自动驾驶数据与具身智能数据的区分主要体现在数据来源、结构、应用目标及技术挑战等多个维度。以下是综合对比分析:

1. 数据来源与采集方式

1)自动驾驶数据:

来源:依赖车载传感器(摄像头、激光雷达、毫米波雷达等)采集环境信息(道路、车辆、行人、交通标志)及车辆状态(速度、转向角、加速度)。

采集特点:以被动感知为主,强调“无交互”(避免碰撞),数据生成场景集中在结构化道路环境(如高速公路、城市街道)。

2)具身智能数据:

来源:通过机器人的多模态传感器(视觉、力控、触觉、关节状态传感器)收集环境交互数据,例如抓取物体、开门、叠衣服等动作的物理反馈。

采集特点:需主动操控物理世界,强调动态交互(如调整抓取力度、适应物体形变),场景覆盖居家、工业、商超等非结构化环境。

3)补充说明:“避免交互” 与 “创造交互” 的相对性

2. 数据类型与结构

1)自动驾驶数据:

类型:以时序连续的感知数据(图像、点云)和车辆控制信号(刹车、转向指令)为主,结构相对统一。

标注需求:依赖人工标注物体边界框、车道线等,或通过仿真生成corner case(如极端天气、事故场景)。

2)具身智能数据:

类型:包含高维动作序列(关节角度、末端执行器轨迹)、物理交互反馈(力/力矩、触觉纹理)、任务技能(如“倒水”“折叠衣物”)的多层次数据。

结构复杂性:需关联动作-效果链条(例如“推门力度”与“门开角度”的关系),数据非结构化程度高。

3)补充说明:任务边界的模糊性

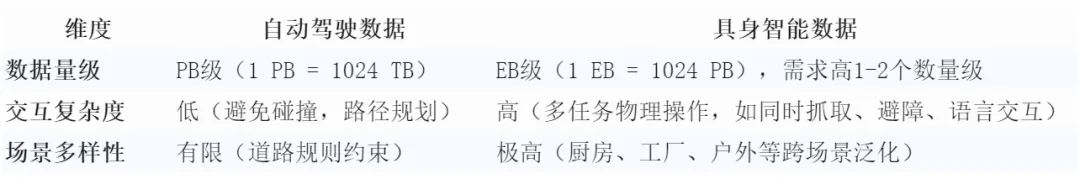

3.数据规模与复杂度

4.应用目标与环境特性

1)自动驾驶:

目标:实现安全、高效的A点到B点移动,核心是环境感知与轨迹规划,依赖高精度地图和交通规则。

环境约束:道路边界清晰,交互对象(车辆、行人)行为可预测性较强。

2)具身智能:

目标:完成开放世界的多步骤任务(如“整理房间”),需结合物理交互、常识推理与即时决策(如判断玻璃杯易碎性)。

环境动态性:物体状态实时变化(如水杯倾倒),需持续适应物理反馈。

5. 技术挑战与数据需求差异

1)动驾驶数据挑战:

长尾问题:极端场景(暴雨、遮挡)数据稀少,依赖合成数据填补(占比30–40%)。

安全验证:需海量里程数据证明系统可靠性(如亿公里级测试)。

·

2)具身智能数据挑战:

物理真实性:需高保真仿真(如柔体动力学、触觉反馈),合成数据占比超90%。

跨任务泛化:同一动作在不同场景(如“开门”在家vs.仓库)需差异化数据支持,存在 Real2Real Gap(真实场景间差异)。

6. 未来趋势融合点

VLA(Vision-Language-Action)模型:两类数据均向多模态大模型收敛。自动驾驶的“感知-规划”与具身智能的“感知-动作”闭环可统一为行动令牌(Action Tokens),实现跨领域策略迁移(如自动驾驶的避障逻辑用于机器人导航)。

合成数据驱动:两者均依赖合成数据解决数据荒,但具身智能对物理仿真精度要求更高(如模拟布料形变、液体流动)。

总结

自动驾驶数据是任务单一、环境结构化的被动感知流,核心是“避免交互”;具身智能数据则是任务开放、环境非结构化的主动交互流,核心是“创造交互”。前者追求安全与规则遵循,后者追求物理世界的适应性创造,这种根本差异决定了二者在数据形态、规模及应用逻辑上的本质区别。

版权声明

本文仅作者转发或者创作,不代表旺旺头条立场。

如有侵权请联系站长删除

旺旺头条

旺旺头条

发表评论:

◎欢迎参与讨论,请在这里发表您的看法、交流您的观点。